Co to jest „Punkt Odcięcia Wiedzy” (Knowledge Cut-off) w AI?

Zapytałeś kiedyś starszą wersję ChatGPT o wczorajszy mecz lub o najważniejsze wydarzenie z zeszłego miesiąca, a on odpowiedział: „Niestety, moja wiedza kończy się na [data]”?

To właśnie jest „Knowledge Cut-off”, czyli Punkt Odcięcia Wiedzy.

Jest to po prostu konkretna data (np. kwiecień 2023), do której zebrano dane użyte do treningu danego modelu AI. Oznacza to, że model nie ma absolutnie żadnej wiedzy o wydarzeniach, faktach, ludziach ani danych, które pojawiły się na świecie po tym dniu.

Knowledge Cut-off w 30 sekund

- Co to jest? Ostatni dzień, z którego pochodzą dane treningowe modelu AI. To jak data druku podręcznika, z którego uczył się model.

- Dlaczego istnieje? Trening modelu LLM jest niezwykle drogi (miliony dolarów) i czasochłonny (trwa tygodniami lub miesiącami). Nie da się go aktualizować „na żywo”.

- Jak AI to obchodzi? Nowoczesne chatboty (jak Gemini czy ChatGPT Plus) używają techniki RAG (Retrieval-Augmented Generation), aby przeszukać internet na żywo i znaleźć aktualne informacje, których ich „mózg” nie posiada.

Analogia: AI jako Student z Podręcznikiem

Najłatwiej to zrozumieć na przykładzie. Wyobraź sobie, że model LLM to genialny student, który przygotowuje się do egzaminu z wiedzy o świecie.

Jego jedynym materiałem do nauki jest gigantyczny podręcznik historii, który został wydrukowany w kwietniu 2023 roku.

- Student ten wie wszystko o świecie do kwietnia 2023 z niesamowitą precyzją.

- Nie ma jednak bladego pojęcia, kto wygrał wybory w październiku 2023, jaki film zdobył Oscara w 2024 ani jaka jest dziś pogoda.

Ten student to „zamrożony w czasie” mózg AI. Data „kwiecień 2023” to jego Knowledge Cut-off.

Dlaczego AI nie uczy się „na bieżąco”?

To częste nieporozumienie. Kiedy rozmawiasz z ChatGPT, on nie uczy się z tej rozmowy ani nie aktualizuje swojej wiedzy na stałe.

Trening modelu LLM to nie jest dodawanie nowych plików do bazy danych. To potwornie skomplikowany, drogi (kosztujący miliony dolarów w energii i mocy obliczeniowej) i długi (trwający wiele tygodni) proces ponownego „przetwarzania” całego internetu i „ustawiania” miliardów parametrów w jego cyfrowym mózgu.

Dlatego firmy wypuszczają nowe modele (GPT-4, potem GPT-4.5, potem GPT-5) co jakiś czas, zamiast aktualizować jeden model codziennie.

Jak więc AI zna wczorajsze newsy? (Rozwiązanie: RAG)

No dobrze, ale przecież gdy pytasz dziś Gemini o pogodę, on odpowiada poprawnie!

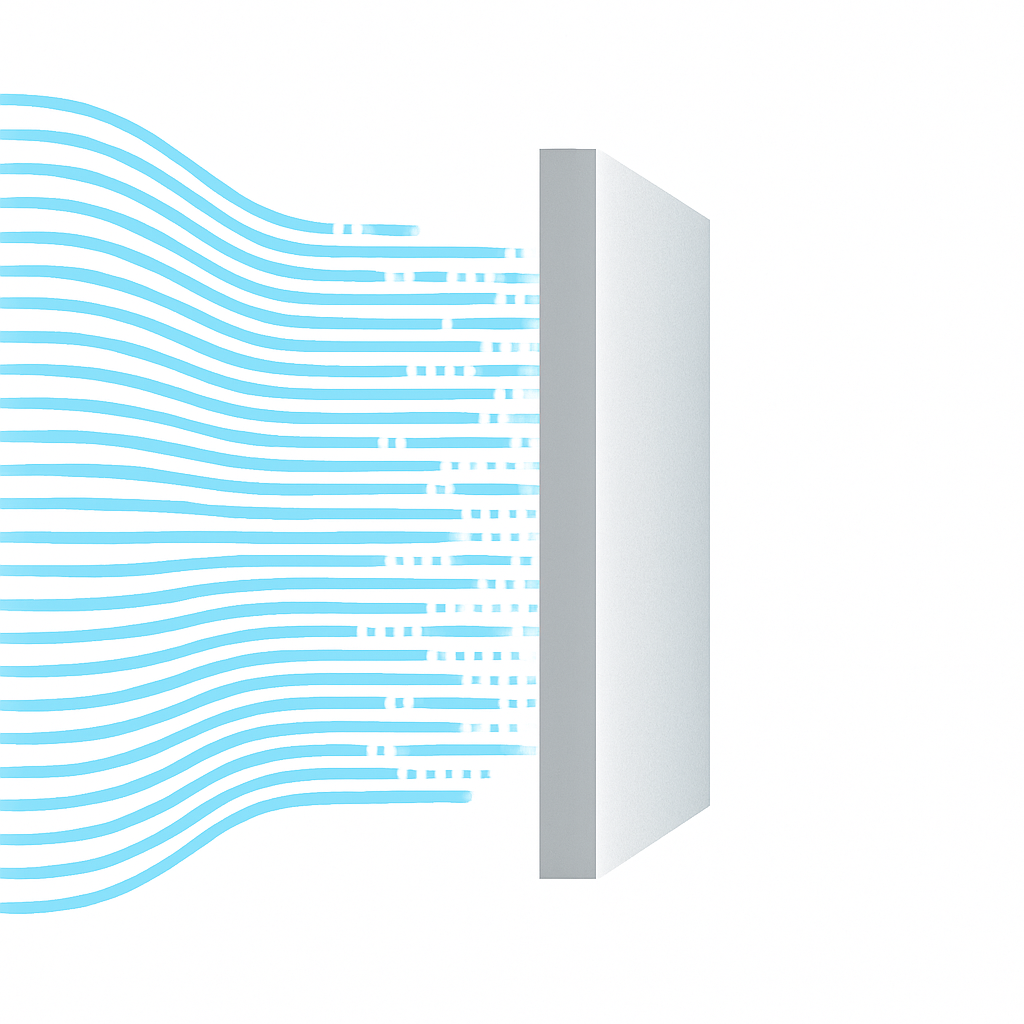

Dzieje się tak dlatego, że nowoczesne chatboty „oszukują” ten system. Nie polegają tylko na swoim „zamrożonym” mózgu. Używają techniki, którą opisaliśmy w artykule „Co to jest RAG?”.

Gdy zadajesz aktualne pytanie:

- System zanim zapyta AI, najpierw przeszukuje internet na żywo (np. przez Google).

- Znajduje trafny artykuł (np. z prognozą pogody).

- Następnie „dokleja” ten artykuł do Twojego prompta i każe modelowi AI: „Odpowiedz na pytanie o pogodę, bazując tylko na tym tekście.”

W ten sposób sam „mózg” AI (LLM) nadal nie wie, jaka jest pogoda, ale potrafi genialnie przeczytać i streścić tekst, który mu dostarczyłeś.

Podsumowanie

„Punkt Odcięcia Wiedzy” to fundamentalne ograniczenie Dużych Modeli Językowych. Zrozumienie go jest kluczowe, aby wiedzieć, dlaczego AI może się mylić w kwestii aktualnych faktów. Technologia RAG jest obecnie najważniejszym pomostem, który łączy statyczną, historyczną wiedzę modeli z dynamicznym, realnym światem.